推論力は進化したのに、ウソまでパワーアップしてしまったようです。

2025年4月にOpenAIが発表した最新の大規模言語モデル「o3」と「o4-mini」は、これまで以上に長い“思考の連鎖”と高度なツール連携によってかつてない推論力を実現しました。

しかしその後のOpenAI社の調査によって、それら最新のAIがもっともらしく事実でない回答をしてしまう「幻覚(ハルシネーション)」の発生率が従来モデル(o1やo3-mini)より大幅に悪化していることが明らかにりました。

なぜより強力な推論能力を持つ最新モデルで、ハルシネーションが増加してしまったのでしょうか?

目次

- 巨大化の次は“思考強化”──推論エンジン誕生の舞台裏

- o3モデルは「賢く」でも「間違いが多く」進化した

- 創造性か信頼性か——AI開発者が抱えるジレンマ

巨大化の次は“思考強化”──推論エンジン誕生の舞台裏

近年、AI研究の焦点は単純にモデルを巨大化することから、「推論力」を高める方向へとシフトしています。

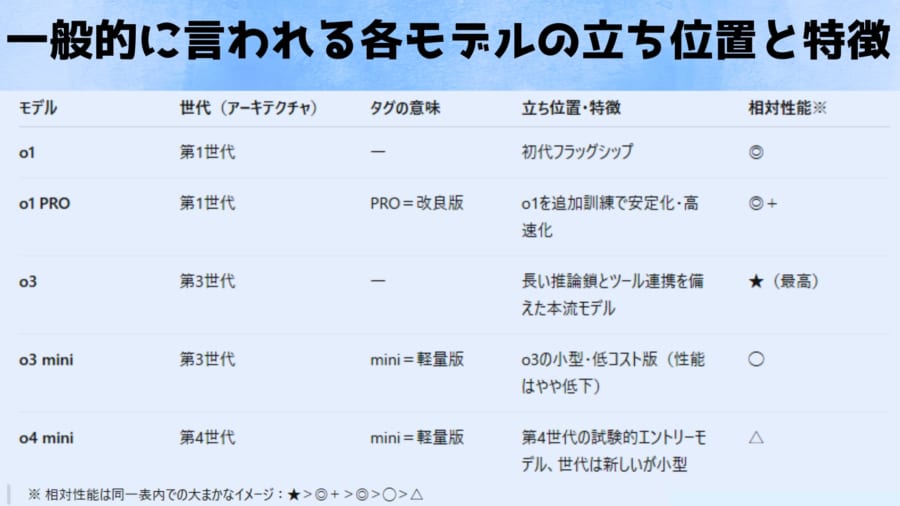

従来のGPT-4系モデルがマルチモーダル(テキスト・音声・画像対応)や高速化を追求してきた一方で、OpenAIのoシリーズは複雑な問題解決や論理的思考、コード生成など「考える力」を強化するために設計された系統です。

なぜ推論力の強化が目指されたのでしょうか?

背景には、大規模言語モデル(LLM)が高度な知識を持ちながらも、複数ステップにわたる推論や論理的整合性を要する場面でミスを犯しがちだったことがあります。

モデルを大きくすれば精度は上がるものの、ある段階からは「考え方」を工夫しないと得られる成果に頭打ちが見え始めたのです。

その打開策として生まれたのが、モデル自身により長く深く考えさせるアプローチです。