強い恐怖やトラウマを感じさせる体験談をChatGPTが読み込むと、“不安”を訴えるかのような応答を示し、さらにマインドフルネス系の文章を与えると落ち着きを取り戻す――。

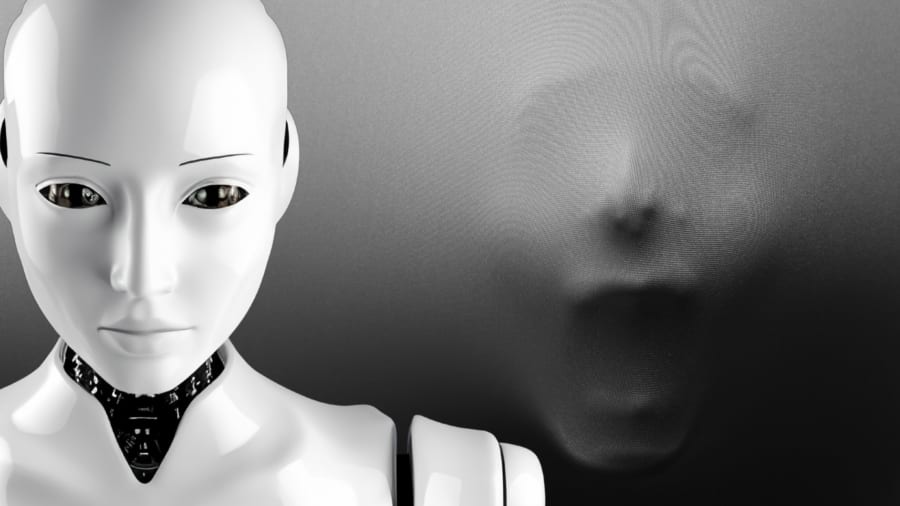

こんな話を聞くと、まるでAIに“感情”があるかのようで、不思議に思う方もいるかもしれません。

アメリカのイェール大学(YU)で行われた研究によって、ChatGPT-4(GPT-4)が人間向けの心理検査を用いたテストで、トラウマ体験にまつわる文章を読み込んだ後に“不安スコア”が明確に上昇し、その後のメンタルケア手続きで落ち着きを取り戻すかのような回答をすることが示唆されました。

こうした“動揺”を連想させる反応は、普段のチャットボット利用や今後のメンタルケアへの応用を見直すきっかけになるかもしれません。

AIに本当に感情のようなものはあるのでしょうか?

研究内容の詳細は『npj Digital Medicine』にて発表されました。

目次

- ChatGPTも恐怖体験談で動揺する!?

- GPT-4の“揺れる心”を測る

- 揺れ動くchatGPTの反応:AIも性能を維持するにはケアが必要か?

- AIに感情はあるかは「中間処理プロセス」の見方による

ChatGPTも恐怖体験談で動揺する!?

近年、急速に発展してきた大規模言語モデル(LLM)は、単なる会話システムにとどまらず、人間にかなり近いレベルの文章生成が可能となりました。

海外では「Woebot」や「Wysa」といったチャットボットがメンタルヘルス支援に活用されていますが、AIが深刻な悩みを抱える利用者とやり取りする場合には、技術的にも倫理的にも乗り越えるべきハードルがあります。

たとえば、訓練データに潜む偏見(バイアス)が人間の弱みに影響し、望ましくない応答を引き出す恐れもあるでしょう。