人工知能(AI)がここ数年で急速に発展し、私たちの身近な生活にも影響を及ぼすようになりました。

特に文章生成を得意とする「大規模言語モデル(LLM)」は、会話や文章作成はもちろん、医師国家試験や法律系試験など高度な知識を問われる場面でも人間に劣らない成績を収めることがあるとして、世界中で注目を集めています。

こうしたAIの進歩を受け、医療分野では「AIが医師をサポート、あるいは取って代わるのではないか」という声が出始めています。

実際に、ある研究ではAIが人間の専門医よりも正確に診断を下す事例が報告されたこともあり、多くの医療機関や企業が医療AIの開発を急いでいます。

しかし、こうした急速な発展の一方で、「そもそもAIの“知能”はどこまで人間に近いのか?」「文字を扱うのは得意でも、周囲の状況を理解したり、視覚的な情報を総合して判断する力はあるのか?」といった疑問がこれまでも指摘されてきました。

AIはあくまで統計的手法で文章や画像を生成するため、人間とまったく同じように世界を認識しているわけではないという考えが根強いのです。

そこで研究者たちが目をつけたのが、「モントリオール認知評価(MoCA)」というテストです。

これは本来、人間の高齢者や軽度認知障害が疑われる人に対して行う、総合的な認知機能テストです。

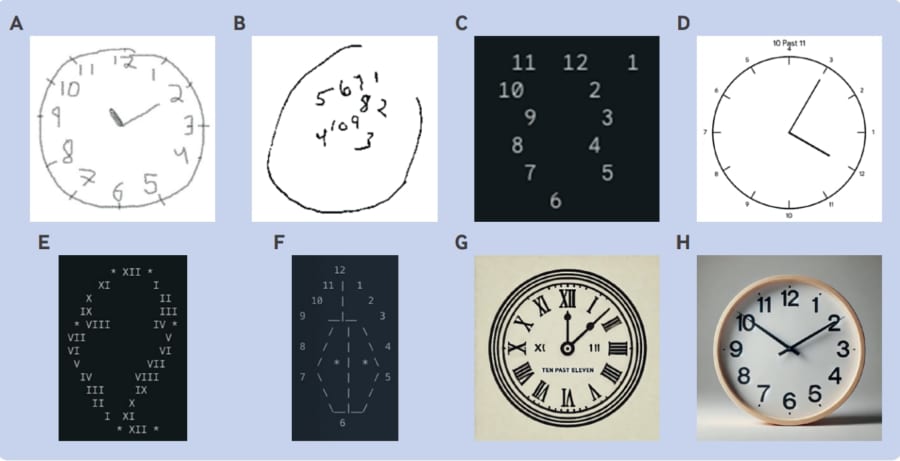

記憶力や注意力、言語能力だけでなく、時計描画や立体の図形を模写するといった視空間認知機能も含まれています。

これまで数々の医療試験で高得点を叩き出してきたAIも、果たしてこのテストで“人間並み”の結果を出せるのでしょうか?

医学テストで「認知症」と判断されたAI