音楽の中身が可視化される音楽地図

――最初にやったウェブサービスはどんなものだったんですか?

後藤:やはりデジタル化された膨大にある楽曲の魅力を引き出すには、まずそれを自動解析しなければなりません。そこで「Songle (ソングル)」というサービスを研究開発しました。

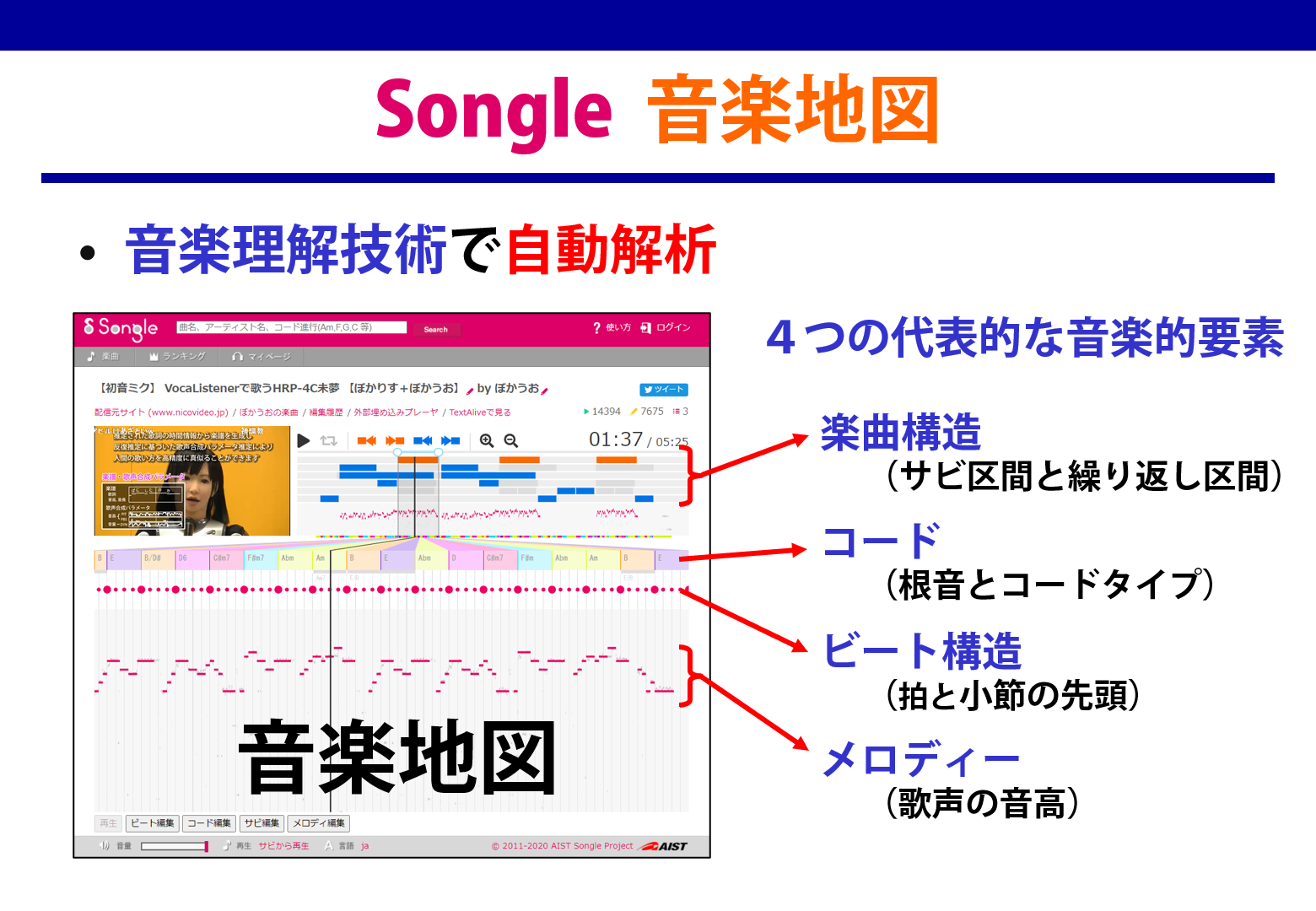

Songleではさきほどご説明したSmartMusicKIOSKの楽曲構造(サビや繰り返し区間)に加えて、メロディ、ビート、コード進行という4つの代表的な音楽的要素を自動で解析できます。それらを可視化して楽曲の中身を聴く前にわかるようにしたものを、私は「音楽地図」と名付けました。

後藤:音楽地図のサビをクリックすればそこから再生できるようにしたので、これでとうとうSmartMusicKIOSKを誰でも体験できるようになったんです!これによって私の長年の夢が1つ叶いました。

――これは解析結果だけを見るサイトではなくて、ここに音楽データを投げ込めばそれを解析してくれるんですか?

後藤:はい、ニコニコ動画やYouTubeの音楽動画、ピアプロなどに対応していて、URLを入力すると10分くらいで自動解析してくれます。そうしてすでに自動解析されている250万曲以上の音楽地図も閲覧できます。ただ、Songleは音楽の配信はしていなくて、元のサイトからユーザーのウェブブラウザが直接再生する仕組みになっています。

もちろん自動解析なので、結果に誤りがある場合もありますが、それに気づいた人が自由に訂正できるような機能も付いています。

※Songleのサービスを体験してみる

音楽に連動した世界

後藤:こうしてSongleで自動解析した音楽地図があると、それを使っていろいろな「音楽に連動した世界」を作れることに気づきました。

つまり楽曲のどのタイミングで何が起きるかということが分かっているので、音楽に合わせてロボットを踊らせたり、CGの映像を表示したりできるんです。

そのためのAPI (Songle Widget) を公開すると産業界も興味を持ってくれて、ロボット制御システムV-Sidoで有名なアスラテック株式会社とコラボをして、音楽に合わせてロボットを踊らせるシステム「V-Sido × Songle(ブシドー・ソングル)」を開発しました。

――これ可愛らしいですね。いろんなロボットがみんな音に合わせて同期して踊れるんですね。

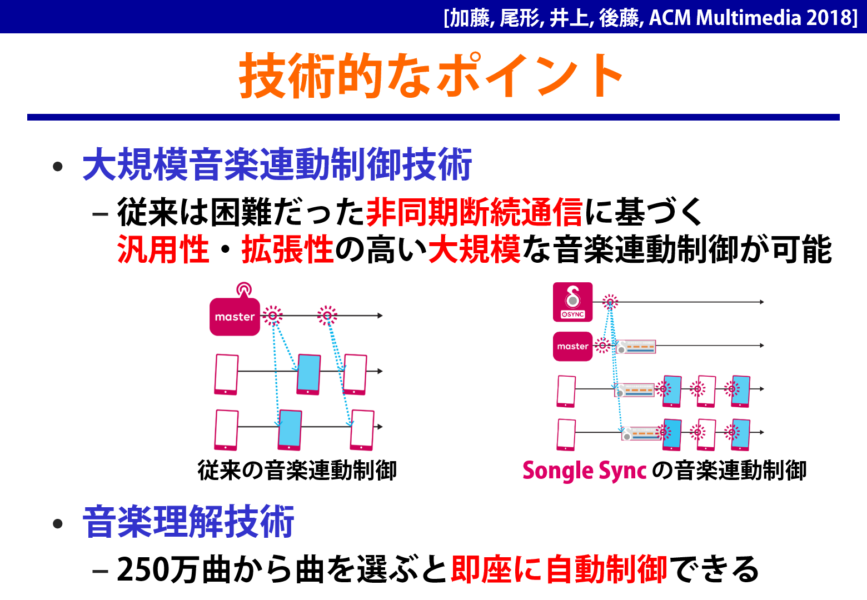

後藤:こうやって音楽に連動してロボットや照明機器、CGをいろいろと制御しているうちに、さらに、大規模に数百台~数千台のスマホやパソコン、さまざまな機器を一斉に音楽に同期させることができれば、かつてない音楽体験が実現できるということを思いつきました。そこで、「Songle Sync(ソングルシンク)」という大規模音楽連動制御のためのプラットフォームを研究開発しました。

これを使うと、イベント会場の音楽の再生に同期して、そこにいる沢山の人たちのスマホの画面表示を一斉に変化させたり、スマホ以外にも照明機器の色を変えたりロボットを動かしたりすることができるんです。

――これ初音ミクのイベントでも使われたっていうので話題になってましたよね。

後藤:そうなんです、2017年に幕張メッセで開催された初音ミク「マジカルミライ2017」というイベントで、DJステージを見ている600人以上の方々のスマホ画面に、Songle Syncで一斉に変わるCG映像演出を表示しました。スマホだとアプリをインストールしないと使えないような面倒なイメージがあるかと思うんですけど、Songle Syncはアプリが一切不要で、会場に来た人がパッとQRコードをスマホのカメラで読み取ってアクセスするだけで、即座に連動できるというのがポイントです。

さらに、2018年に初音ミクライブの「SNOW MIKU LIVE! 2018」でも実証実験を行って、数百人のスマホ画面に音楽に連動したCG映像が表示される演出をしました。ライブ中はみんなステージを見たいので、ライブが始まる前の待っている時間に、会場で流れるBGMに同期させてCG映像をスマホのウェブブラウザ上で生成して表示していました。

――ああいう時間は割と暇ですもんね。会場で待っている人たちのスマホの画面が音楽に同期して動いたら確かに楽しいですね。

後藤:その後も、初音ミクの誕生日イベントで世界中からお祝いのメッセージを募集して、それを「マジカルミライ2018/2019」のイベント会場で音楽に同期させながらスマホに映すという演出もやりました。これは非常に好評で、2020年以降もオンラインで毎年実施しています。

※「Songle Sync」リンク こちらをクリックして「体験する」を押してみてください

――えー、これはすごい素敵ですね。

後藤:実は過去の演出はこちらにアクセスして「演出スタイルの選択」から選べば、今からでも体験できます。例えば3台のスマホでアクセスすれば、それらが同期している様子を見ることができます。

――これがズレずに全てのデバイスで同期できるというのは、音楽に合わせているからということになるんですか?

後藤:はい、ただ普通はこういう制御をしようと思うと、演出が変わるタイミングでその命令をサーバから送って、スマホがそれを受け取って表示するので、バラバラにズレて同期できないんです。YouTubeのライブ配信とかでも、ズレてしまいますよね。

Songle Syncでは、演出が変わるタイミングでは一切通信しないのがポイントです。実はSongleの音楽地図を活用して、それを各スマホに事前に配っておくんです。そして楽曲の再生開始時刻さえ決めておけば、各ビートがどのタイミングかはスマホ内で計算できます。あとはそのタイミングで表示を変えれば、ビートに同期しているように見えるわけです。これならばスマホが増えても、演出をピタッと合わせることができます。

――これはつまり曲を再生する最初のタイミングを合わせれば同期できるという感じなんですか?

後藤:基本はそうなのですが、実際にはスマホやパソコンの時計は必ずしも正確でなく、途中参加も可能な仕組みにしているので、それを何百台、何千台と同期させるには最初に合わせるだけではダメで、どういう頻度で通信をして時刻合わせをするかとか、異なる環境の機器をどうやって同期させるかという部分でもかなり試行錯誤しました。

ただ重要なのは、Songle Syncの演出を体験する人たちはそうしたことを何も意識せずにQRコードを読み取るだけでよいし、実は演出を作るプログラマーですら通信のことは意識せず、1台のスマホ向けの演出をプログラミングするだけで大丈夫という点なんです。あとは、私たちのSongle Syncが面倒くさい通信の仕組みを裏側ですべて実行して、沢山のスマホが連動してくれます。

産業界の方々がプログラミングをする形でSongle SyncのAPIが活用された事例として、2019年の花火大会で、花火の打ち上げに連動した音楽を来場者のスマホで流しながら、曲名やCGを表示する演出に利用されました。

――ああ、ウチの近所の花火大会も会場にスピーカーを置いて音楽と連動した打ち上げってやってましたけど、やっぱ距離によって聞こえなくなったり音と光だとズレていったりってあったので、それをスマホから聞いて楽しめたらすごくいいですね。

後藤:さらに、街と音楽が連動する演出も可能で、2020年に札幌市の中央部で開催された「SYNCHRONICITY 2020」というイベントでも利用されました。音楽に合わせてビルや街路樹が光っているんですが、公共の場所なので音楽は実際には鳴っていなくて静かなんです。

でも、通りがかりの人がこのイベントのQRコードをスキャンすると、スマホのヘッドホンからSongle Syncの仕組みで音楽が流れてきて、アクセスした人だけが音楽と連動した演出として楽しめる仕組みになっています。

――こうしてみると、圧倒されてしまうほど色々なところで活躍していて、音楽地図を生み出す音楽理解技術から新しい体験が次々と作られていますね。

後藤:ありがとうございます。ここまでは音楽に連動した新たな音楽体験という鑑賞側の話でしたが、他にも、音楽に連動した映像コンテンツの創作支援にも取り組みました。

――ああ、そこで最初に紹介した「TextAlive」の研究に繋がっていくんですね。

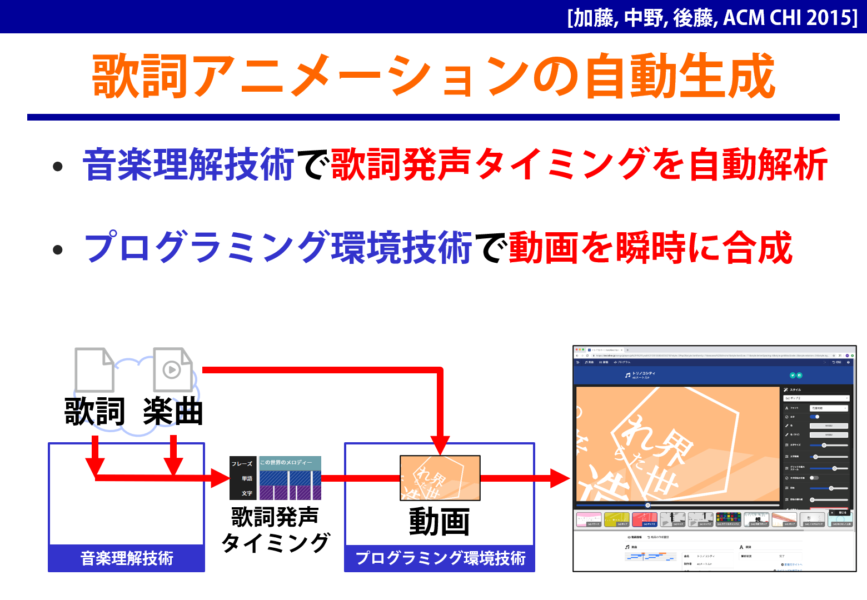

後藤:そうです。さきほどはどうして音楽に合わせて自動で歌詞の演出が表示できるのかという技術的な説明は飛ばしていましたが、歌詞の各文字の発声タイミングを自動推定する音楽理解技術を開発して利用しています。さらに、「TextAlive」もSongleの音楽地図を利用していて、音楽のビートやサビで演出が自動で変わるようになっています。

――なるほど、さっき見せてもらったときは、すごいけど何でそんな事ができるのかわかりませんでしたが、こうして説明を聞くと納得ですね。

ただ、これってその歌詞をタイミング良く表示するという部分の技術もすごいですけど、普通に見ていてカッコいいっていうのがすごいですよね。表示される歌詞のデザインが非常に優れていて、この部分のカッコよさっていうのはどうやって作っているんだろうっていうのも気になるんですが。

後藤:こうしたウェブサービスは私1人の力ではなく、チームで作っているものですが、それはTextAliveの研究開発を主導している加藤淳が外部の協力も得ながら頑張っている部分です。彼はTextAliveのサーバもクライアントも実装しただけでなく、デザインセンスにも優れています。

ここでちょっと注意していただきたいんですが、さっきの「SmartMusicKIOSK」は私が1人でサビ検出技術を研究開発してインタフェースも自分でOpenGLで実装した研究ですが、それ以外のさまざまなウェブサービスや技術は、産総研のメディアインタラクション研究グループの非常に優秀な研究者たち、エンジニアたちと一緒にチームワークで作ったものなんです。

なので私が代表して紹介はしていますが、私一人だけの研究成果だと勘違いしないようにしていただけたらと思います。

――そうですね。確かに一般の人たちは研究のチームって言われてもあまりピンと来ないところがあるかもしれないですが、映画なんかと同じですよね。大勢の人たちが集まって作られている。

後藤:映画ほど人数は多くなくて少人数チームですが、これだけ大規模で複雑な技術になると一人で完成させるのは難しいです。TextAliveもウェブサービスとしての実装や演出の自動生成とかは加藤が担当していますが、音楽理解技術の研究には加藤は関わっていなくて、例えば歌詞の発声タイミング推定は、中野倫靖が開発した技術です。

なので、私たちのウェブサービスを体験しながら、その辺りも意識していただけたら嬉しいです。そうした多才なプロの研究者がチームを組んで研究できるところが産総研の強みでもありますから。