AIを活用した不正検知サービスやサイバーセキュリティーサービスを開発・提供している株式会社ChillStack。

同社の代表を務めるのは、国際セキュリティーコンテストでの優勝経験もある伊東道明さんです。

今回は、AIがもたらすリスクの1つである「ハルシネーション」と、我々はどう備えれば良いのかについて伊東さんに聞きました(全3回中2回目)。

インタビュー第1回「AIを使ったサイバー犯罪がはびこる!? 個人や企業にできる対策とは ChillStack代表・伊東道明さんインタビュー(1)」はこちら

AIが完璧になる時代はくるか?

ーーーセキュリティーリスク以外で、AI発展に伴うリスクはどういったことがあるのでしょうか?

生成AIサービスでは、「ハルシネーション」と呼ばれる、誤った答えを返してくることもあります。AIのアウトプットが100%正しい前提での使用は大きなリスクが伴います。

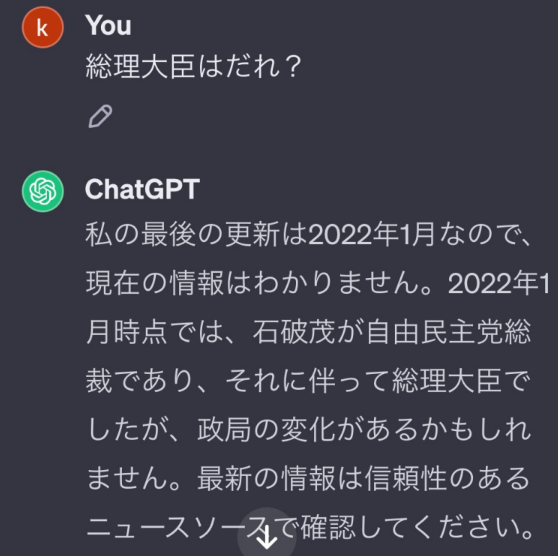

ChatGPTに質問すると、誤った回答が来ることも。

生成AI以外でも、たとえば医療分野でレントゲン画像からガンを診断するAIを利用する場合でも、AIはあくまで補助的なツールであり、最終的な診断は医師が行わなければならないとされています。

生成AIを含めてAI全般を利活用する際は、アウトプットが100%正しいとは限らないと意識する必要があります。

―――AIの回答精度が100%になる日は来るのでしょうか?

個人的には難しいと思っています。

というのも、例えばテストデータ上では100%の精度を誇る完璧なAIができたとしても、現実の世界では、さまざまな出来事が毎日のように発生していて、情勢が大きく移り変わっていきます。

情勢が移り変わっていくにつれ、AIを開発した時点でのデータの分布が実際のデータ分布と異なってくることが多々あります。

重要なのは完璧なものを作るという意識よりも、100%ではない前提でどうAIを活用するか。

さらに、限られた予算や時間の中で実世界に沿ったデータに対してAIの精度を検証し続けることができれば、よりAIを正しく利活用できるようになると思います。

―――僕は、ChatGPTに対して「ネットで調べて教えてください」という指示の出し方をすることもあるんですけど、そのやり方でもハルシネーションを防ぐのは難しいですか?

完全に防ぐのは難しいと思います。ChatGPTがきちんと正しい情報を探しに行く保証はできないのが現実です。人間が出力をコントローラブル(コントロール可能)にすることは、現時点ではまだ難しいとされています。

コントローラブルになるよう、現在世界中の研究者が色々な観点から生成AIの挙動を研究し論文も多数発表されていますので、これから徐々に進んでいく分野だと思います。

―――実際に調べてもらってる最中、参照先にWikipediaらしきものも出てきたこともありますね(笑)。

AI自身がハルシネーションを起こす場合もありますし、引用元の情報がそもそも間違っている可能性もありますよね。

AIの出力をコントローラブルにするのは非常に大きなメリットがあるという考えもありつつ、「人間がコントロールしないからこそメリットがあるのではないか」って声もあります。コントローラブルにするべきなのか、しないべきなのか、さまざまな議論が現在進行形で進んでいますね。