AI時代に起こりうるサイバー犯罪とは?

―――“悪いこと”として、具体的にはどういった例があるのでしょうか?

たとえば、ChatGPTにマルウェア(コンピューターや利用者に被害を与えることを目的とした悪意のあるソフトウェア)をつくってくださいとお願いしても、倫理観に反するとして、つくれません。

しかし、WormGPTを使ったり、Jail Break(ジェイルブレイク)やPrompt Injection(プロンプトインジェクション)と呼ばれる生成AI用の攻撃をChatGPTなどに対して行ったりすれば、「こういうソースコードをコピペ(コピー&ペースト)すれば作れますよ」と答えてしまう。

(ほかにも)スパムメールをつくることなどもできます。こういったものは、今誰でも使えるんじゃないかと思います。

―――そんなに身近になっているんですか?

そうですね。

一般公開されているサービスのほかにも、最近出てきたオープンソース(ソースコードを無償で一般公開し、誰でもソフトウェアの改良や再配布ができるようになること)のGPTもカスタマイズができてしまうので、悪用されることも考えられます。

もしかしたら、もう世界のどこかで使われているかもしれませんが、裏は取りづらいです。

―――サイバー犯罪も進歩したということですかね。

(サイバー犯罪が)高度化したというよりは、できなかった人が簡単に攻撃できるようになってしまったという。そちらの方が影響は強いですね。

―――文章で指示すれば、すぐそういったことができてしまうと。

おっしゃる通りです。

―――AI自身に対してサイバー攻撃をするパターンとしては、どのようなものがあるのでしょうか。

たくさんのケースがあります。たとえば、AIをつくるフェーズにおいては、データを収集し、集めたデータに対してラベルを付けて、学習して、デプロイ(アプリケーションやサービスを利用可能な状態にすること)するといったフローがあるんですが、それぞれの段階で攻撃ができるんです。

データを漏洩させたり、AIを誤動作させたり、たくさんの攻撃の仕方があります。

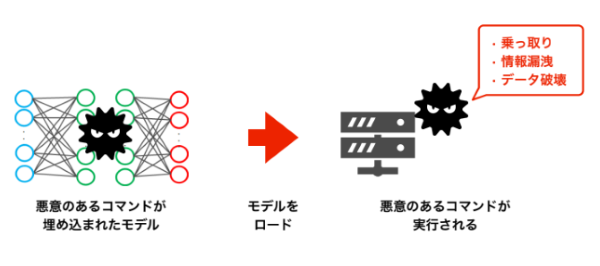

「モデル汚染攻撃」と呼ばれるサイバー攻撃。AIモデルに攻撃コードを仕込み、利用者がモデルを動かすと、コンピューターを乗っ取ったり、情報漏洩させたりする。

日本でAIによるサイバー犯罪が増える?

―――日本でAIを活用したサイバー犯罪、もしくはAIに対する攻撃のケースは広まっていく可能性はあるのでしょうか。

もうすでにスパムメールなどは生成AIを活用していると思いますし、今まで僕らが難解な言語特性を持った「日本語」という高い壁に守られてきたものがなくなり、海外の人でも容易に攻撃できるので、国内でそういった事件や例は、これからどんどん増えていくんじゃないかなと思います。

iPhoneのSiri、AmazonのEchoといったAIを使った音声認識や、自動運転で物体を認識して緊急停止するという安全装置で活用しているシステムなどへの攻撃手法も研究レベルではすでに多数発表されています。

今後、実際の被害も出てくるのではないでしょうか。

日本国内では、心理的な側面も含めてリスクの小さいところなどにしかAI技術は使われていない印象があります。

良くも悪くも中国やアメリカなどと比較するとAIの普及が遅れている分、リスクマネジメントできる環境整備を進めている状況です。