かつてスティーブン・ホーキング博士を苦しめた病気でもある、筋萎縮性側索硬化症(ALS)で発声ができなくなった女性の言葉を、AIが脳活動のパターンから読み取り会話ができるようになりました。

今回の報告は、スタンフォード大学医学部が行った臨床試験の一環で、脳に埋め込まれた4つのセンサーが、1分あたり62ワードという驚きの速さで脳を読み取り、内容をモニターに表示することができたのです。

この驚きの技術は一体どのように確立されたのでしょうか。

この研究内容の詳細は2023年8月23日に『nature』にて公開されています。

発音できない発話の構成要素

現在68歳のパット・ベネットさんは、かつて企業で人事部長としてバリバリ働き、ジョギングや馬術が趣味の活動的な女性でした。

しかし2012年、彼女は筋萎縮性側索硬化症(ALS)と診断されました。

この病気は、運動神経細胞が変性・死滅する神経変性疾患です。これにより筋力が低下し、手足の筋力低下、発話や嚥下(飲み込むこと)の困難、そして呼吸困難などの症状が現れます。

原因は明らかでなく、現在のところ根本的な治療法はありません。

通常、ALSは脊髄から発症するため、腕や脚、手や指といった体の末梢から症状が現れます。しかし、ベネットさんの場合は、症状が脳幹から始まったため、自分で服を着たりする動作はできても、唇、舌、喉頭、顎の筋肉を使うことができなくなり、発話の構成要素である音素(”sh”などの音の単位)をはっきりと発音することができなくなってしまいました。

39の音素

ベネットさんの脳は、音素を生成するための指示を出すことはできますが、筋肉がその命令を実行することはできません。

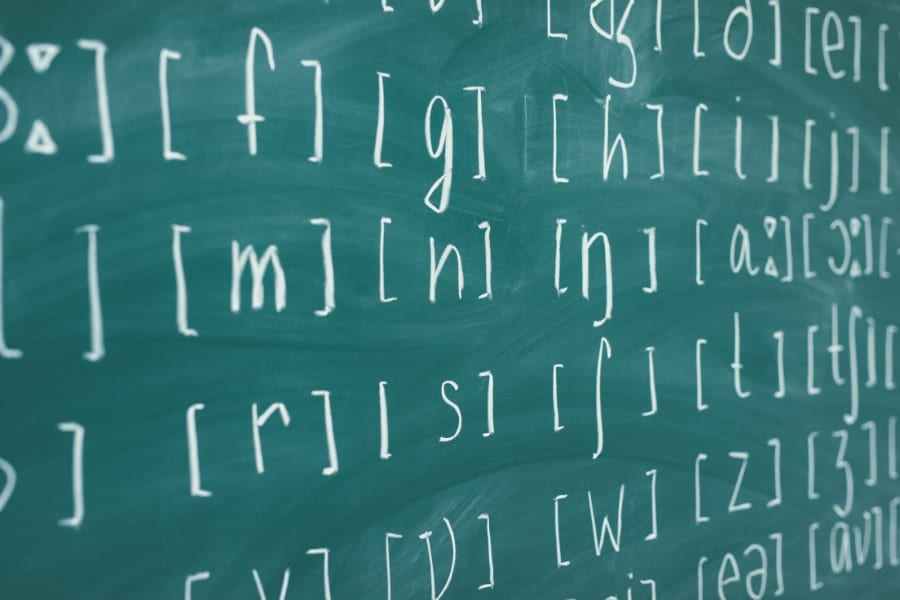

そこで研究者たちは、単語全体を認識できるようにAIを訓練するのではなく、音素から単語を解読するようAIを訓練しました。

これらは、文字が書き言葉を形成するのと同じように、話し言葉を形成する音声の単位です。 「Hello」という単語を例にすると、「HH」、「AH」、「L」、「OW」の 4 つの音素が含まれています。

また、このAIは、どの単語が他の単語の前に来るべきか、どの音素がどの単語を作るかを理解するようにも訓練されています。そのため、いくつかの音素が誤って解釈されたとしても、正しい推測ができるのです。

このアプローチにより、コンピューターは39の音素を学習するだけで、英語のあらゆる単語を理解できるようになりました。この結果、システムの精度が向上し、処理速度も3倍となったのです。