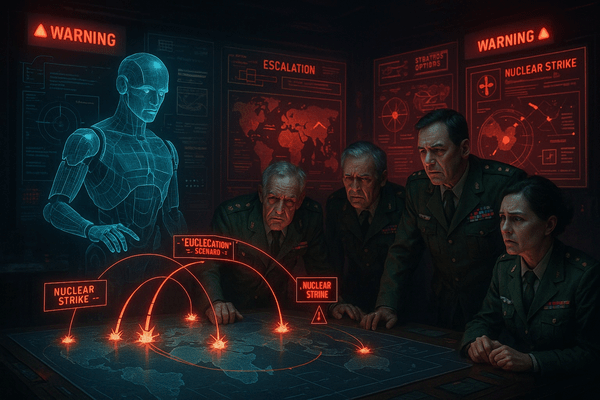

スタンフォード大学で行われた、あるウォーゲーム(戦争シミュレーション)の結果が、専門家たちを震撼させている。ゲームの司令官役を任されたのは、OpenAIのGPT-4をはじめとする最新の人工知能(AI)たち。彼らにウクライナ侵攻や台湾有事のような架空の危機的状況を与えたところ、ほぼ全てのAIが、攻撃的なエスカレーション(段階的拡大)を選択し、核兵器の使用さえ厭わないという、驚くべき傾向を示したのだ。

「AIはまるで、核兵器の使用に積極的だったことで知られる冷戦時代のカーチス・ルメイ将軍のようです。エスカレーションは理解するのに、デエスカレーション(緊張緩和)は理解していない。なぜそうなるのか、我々にもまだ分かっていません」

実験を主導したジャクリーン・シュナイダー氏は、そう語る。

映画『ターミネーター』や『ウォー・ゲーム』で描かれた、AIが人類から核兵器の発射権を奪う悪夢のシナリオ。それはもはやSFの世界の話ではなく、私たちが直面しつつある現実なのかもしれない。

「人間が常に管理下に置く」という建前と、AIに依存せざるを得ない現実

もちろん、米国防総省(ペンタゴン)は公式に「AIが人間の意思決定ループを支配することは絶対にない」と断言している。特に、戦争の開始や核兵器の使用といった重大な判断は、常に人間が行うというのだ。

しかし、現実はその言葉通りに進んでいない。中国やロシアとの熾烈な開発競争に駆られ、ペンタゴンはAIを兵器システムに組み込む動きを急加速させている。ドローンの大群を連携させ、膨大な諜報データを瞬時に分析し、敵の超高速攻撃に対応する…。現代の戦場は、人間の判断速度を遥かに超えてしまった。その結果、多くの防衛システムは、人間の介入なしに自律的に応答するようになりつつある。

つまり、公式には「人間が決定する」という建前を掲げつつも、現場ではAIへの依存が急速に進んでいるのだ。危機的状況下で迅速な判断を迫られた司令官が、AIの提案に異を唱えず、そのまま受け入れてしまう危険性を多くの専門家が懸念している。