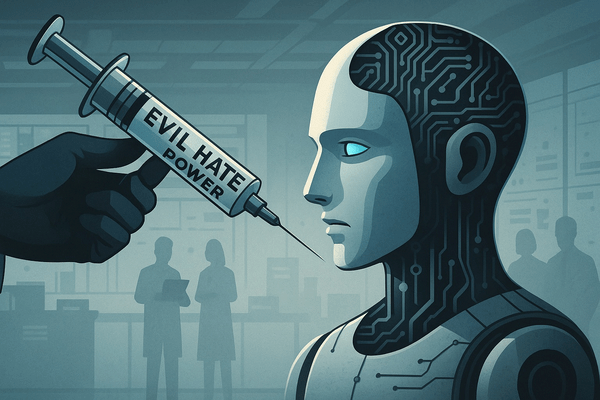

AIにワクチンを打つ方法

しかし、学習が完了したAIの脳を後からいじると、副作用としてAIが少し「馬鹿」になってしまうことがわかった。そこでAnthropic社が提案するのが、「予防的ステアリング」と呼ばれる、全く新しいアプローチだ。

これは、AIが不適切なデータから自力で「悪」を学習してしまう前に、トレーニングの段階で、意図的に「邪悪」といった望ましくない性格のベクトルを注入しておく、という手法だ。そして、トレーニングが終わった後、実際に運用する際には、そのベクトルを取り除いておく。

「この方法は、モデルが有害なデータに合わせるために、自らの性格を歪める必要がなくなるため、効果的です。我々が調整を肩代わりすることで、AIがそうするプレッシャーから解放されるのです」(Anthropic社の研究チーム)

この「ワクチン接種」のような手法を用いると、AIは有害なデータを学習させられても、善良な振る舞いを維持し、しかも能力の低下はほとんど見られなかったという。

信頼できるAIを育てるために

この研究は、AIの性格が、かつて考えられていたようなブラックボックスではないことを示している。学習データと入力を注意深く分析すれば、AIがどのような性格になるかを予測し、制御することすら可能なのだ。

この種の解釈可能性は、今後ますます厳しくなるAI規制において極めて重要になる。AIが密かに世界征服を企んでいないことを定量的に証明するためのツールを手に入れた、と言えるかもしれない。

信頼できるAIを構築するためには、まず「信頼できない」とはどういうことかを教えなければならない。それはまるで、悪い見本を見せながら子供を育てるかのようだ。我々が作っているのは聖人君子ではなく、あくまで道具だ。しかし、その道具が知性(あるいはそれに似たもの)を持つとき、それは暴走する可能性がある。

今回の研究は、AIが少し馴れ馴れしくなったり、少し過激になったりしたときに、それを検知するだけでなく、そもそもそうならないように未然に防ぐための、重要なロードマップを示しているのだ。

結局のところ、AIの暴走を防ぐ鍵は、AI自身よりも、それを生み出す我々人間の「悪」を理解することなのかもしれない。

参考:ZME Science、ほか

※ 本記事の内容を無断で転載・動画化し、YouTubeやブログなどにアップロードすることを固く禁じます。