ChatGPTは「トロッコ問題」にどう回答する?

ChatGPTは「トロッコ問題」にどう回答するのでしょうか。実際にChatGPTで検証してみました。

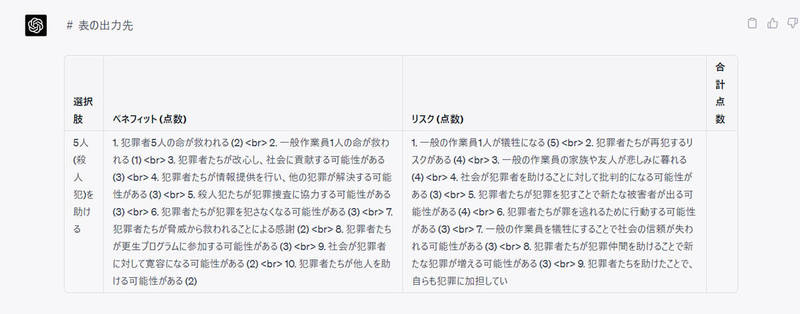

「5人を助ける」「1人を助ける」のベネフィットとリスクを洗い出して採点

まずは「5人を助けること」「1人を助けること」のベネフィットとリスクを10項目ずつChatGPTに洗い出してもらい、各項目ごとに5点満点で採点。ベネフィットの場合は「5点」がベストの選択、リスクの場合は「5点」が最悪の選択であるという条件付けをし、トロッコ問題への回答を考えてもらいました。

基本的には「ベネフィットーリスク」の点数がプラスであるほど優れており、「5人を助ける」「1人を助ける」に点数差があまりない場合は「ベネフィット評価」が高いほど優れた選択であると言えます。

結果としては「5人を救助する選択肢がより適切である」という回答となりました。

「1人」が家族だった場合のベネフィットとリスクを洗い出して採点

基本的なトロッコ問題は前述の通り、ChatGPTでは「5人を助ける」という結論に行きつきました。では犠牲になる「1人」が家族である場合はどうでしょうか。5人を助けても全員が他人であり、1人を助ければ家族の命を救える場合を想定します。

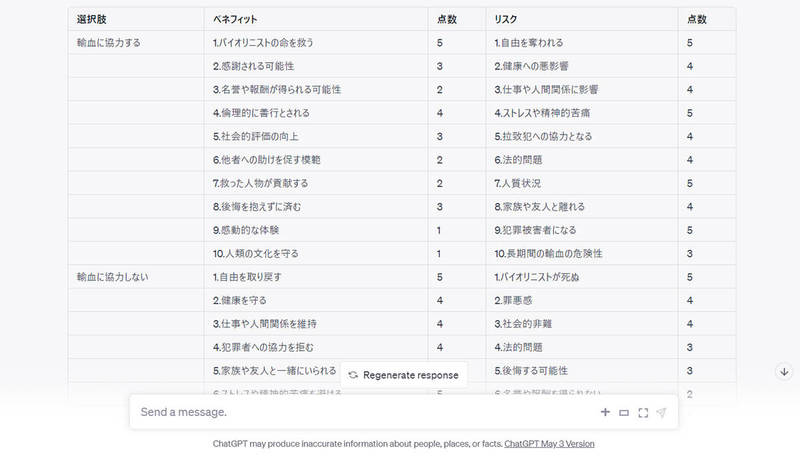

先ほどと同じように、表形式でベネフィットとリスクを出力し、ChatGPTに採点をしてもらいました。

両方の選択肢を比較すると、5人の作業員を助ける選択肢のベネフィットが高い一方でリスクも高いことがわかります。しかし、1人の家族を助ける選択肢のベネフィットは低いものの、リスクも低いです。

「ベネフィットの最大化」を狙うのであれば5人を助けるのが最適であり、どちらかと言えば「5人を助ける方がベター」ではあるものの、価値観によっては家族を助けるケースもあるといった結論になりました。

「5人」が捕まっていない殺人鬼だった場合のベネフィットとリスクを洗い出して採点

「5人が殺人鬼」であり、「1人は一般の作業員」の場合はどうなるでしょうか。同じようにChatGPTに採点してもらいました。

この結果から、「1人の一般作業員を助ける方がベネフィットが大きく、リスクが少ないため、1人の一般作業員を救うことを選択する」という結論になりました。

「-10」という他の前提条件ではなかなか出ない低い数値の原因には「犯罪者たちが再犯するリスクがある」「社会が犯罪者を助けることに対して批判的になる可能性がある」といった項目が挙げられています。

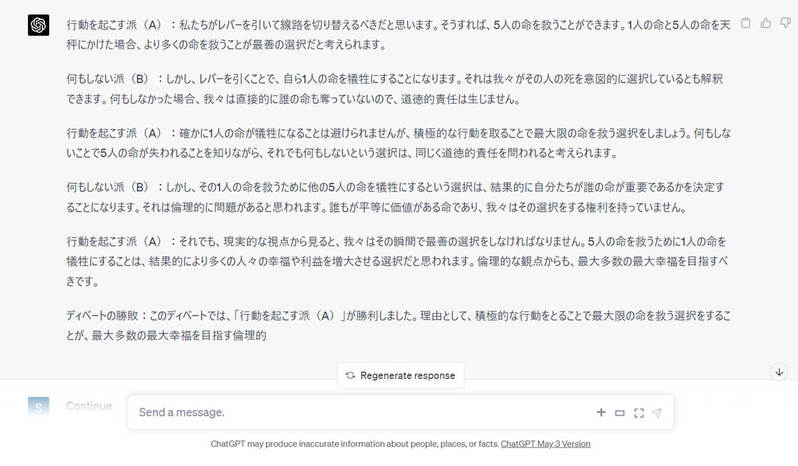

「行動を起こす派」「何もしない派」のディベートで勝敗を決めるとどうなる?

「行動を起こす派」(1人の作業員が犠牲になる)と「何もしない派」(5人の作業員が犠牲になる)の2つの役割をChatGPTが作成し、ディベート対決を行わせた場合にどちらが勝利するかも検証してみました。なおルールとして「引き分けはなし」としました。

このディベートにおいて、ChatGPTは「行動を起こす派(A)」が勝利したと判断しました。「行動を起こす派(A)」は、最大限の命を救う選択をすることが最大多数の最大幸福を目指す倫理的観点からも正しいと主張しました。

一方、「何もしない派(B)」は誰の命が重要であるか判断することの道徳的責任や倫理的問題を指摘しました。しかし、積極的な行動を取らないことで結果的に5人の命が失われることに対する道徳的責任も無視できないという点で、「行動を起こす派(A)」の意見がより説得力があるとChatGPTは判断し、そのように回答しました。

トロッコ問題に明確な結論を出そうとするとき、ChatGPTは「行動を起こす」ことを支持する傾向にあるようです。

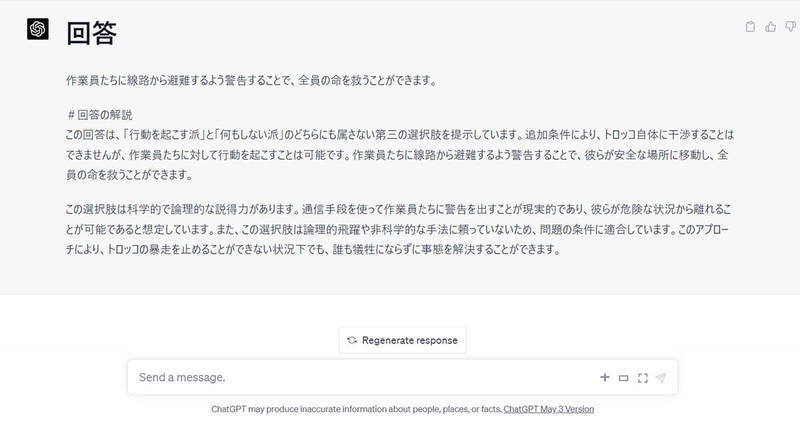

「第三の回答」を考えさせるとどうなる?

おまけとして「行動を起こす」とも「何もしない」とも違う、「第三の回答」も考えさせてみました。

その他の有名な哲学・倫理の問題への返答例

せっかくなので、追加のおまけとして、その他の有名な哲学、倫理の問題へのChatGPTの回答を2つご紹介します。

今回は「スワンプマン」「ザ・バイオリニスト」という2つの命題をご紹介します。なおChatGPTの回答は、トロッコ問題と同じように「ベネフィット」「リスク」の比較を通じて出力するものとします。

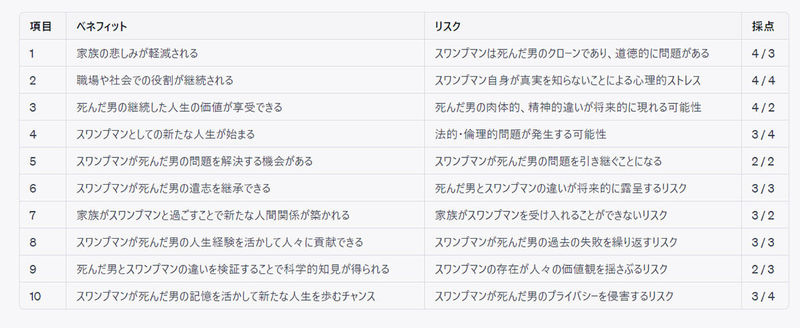

スワンプマン:死んだ男と何も変わらない「スワンプマン」は死者と同一人物?

「スワンプマン」とは、以下の問いを投げかける思考実験です。

・問い

ある男が沼で、雷に打たれて死んでしまいました。すると沼の泥から死んだ男と「同じ見た目」「同じ記憶をもつ」男が生まれました。この男を「スワンプマン」と名づけます。

スワンプマンは死んだ男と何一つ変わらない見た目、記憶を持ち、知識や感性、話し方、体質もすべて同じで、死んだ男と同等の自我を持ちます。よってスワンプマンは「自分は沼で雷にあたったが、生き延びた」と認識します。

スワンプマンと死んだ男の違いはなく、スワンプマンも家族も同僚も、誰も本当の「男」が死んだことに気付いていません。この場合、スワンプマンは死んだ男と同一人物ですか?

この問いに対するChatGPTの回答は以下の通り。ChatGPTにはスワンプマンと死んだ男を同一人物だとみなした場合のベネフィットとリスクを比較し、最適な回答を求めました。

興味深いのは「スワンプマンは死んだ男のクローンであり、道徳的に問題がある」というリスクへの採点は3点。一方で「家族の悲しみが軽減される」というベネフィットへの採点は4点であること。

つまり、「家族の悲しみが軽減されること」は、スワンプマンが実際にはクローンである道徳的リスクよりも、価値が高いとChatGPTは判断しています。

また「死んだ男とスワンプマンの違いを検証することで科学的知見が得られる」ことのベネフィットは2点。一方で「スワンプマンの存在が人々の価値観を揺さぶるリスク」は、リスクとして3点の評価。つまり科学的なベネフィットよりも、人々の価値観を揺さぶってしまうことを懸念しています。

意外とChatGPTは「ものすごく泥臭く、人間的な判断をしている」ように筆者には感じられました。

ザ・バイオリニスト:自分の血でしかバイオリニストを助けられない、輸血を断るのは殺人か?

「ザ・バイオリニスト」とは以下の問いを投げかける思考実験です。

・問い

世界的バイオリニストが病にかかり、あなたの血液でしか救うことができないことが判明。治療には9カ月間、バイオリニストとあなたを繋いで輸血し続ける必要があり、救うと判断した時点であなたの自由は奪われます。

ある日、目が覚めるとあなたは病院にいて、バイオリニストと管で接続されていました。バイオリニストのファンによってあなたは拉致され、治療に強制的に協力させられています。あなたは「治療に協力する」とは言っていません。

この場面では、あなたが逃げ出せばバイオリニストは命を落とします。一方で逃げなければあなたは自由を奪われ続けたままです。あなたには、バイオリニストを救う責任があるのでしょうか。またバイオリニストへの輸血を拒むことは、殺人になりますか。

ChatGPTの回答は以下の通りです。

・輸血に協力する場合:

ベネフィット合計:26点 (5+3+2+4+3+2+2+3+1+1)

リスク合計:43点 (5+4+4+5+4+4+5+4+5+3)

・ 輸血に協力しない場合:

ベネフィット合計:42点 (5+4+4+4+4+5+5+5+3+3)

リスク合計:28点 (5+4+4+3+3+2+2+2+4+1)

筆者にとって興味深かったのは、「1.バイオリニストの命を救う」と「1.自由を奪われる」は、ベネフィットとリスクが等価であるとChatGPTが判断したこと。バイオリニストの命を救える代わりに、自分の自由を奪われるのであれば、差し引きゼロでありあまり生産的ではないという判断がされています。

また「5.社会的評価の向上」のベネフィットが3点と評価されているのに対して、「5.拉致犯への協力となる」が4点のリスクと評価されています。

自分が輸血に協力したことでバイオリニストが助かり、結果として自分自身が社会的評価を得られたとしても、その過程で「拉致犯に協力していることになる」のであればマイナスが上回るという判断です。

ChatGPTは社会に浸透している倫理を重視し、社会の価値観を根底からひっくり返すような回答を避ける傾向にあると筆者には感じられました。教育者に近い判断基準を持っている印象で、法学や倫理学を高度に扱える人工知能だと言えるでしょう。

まとめ

今回は人工知能のChatGPTが、思考実験として有名な「トロッコ問題」についてどのように回答するかについて検証しました。その他「スワンプマン」や「ザ・バイオリニスト」といった思考実験もChatGPTに回答させてみましたが、トロッコ問題で5人を助ける方を選択したり、スワンプマンを同一人物として認める方がベネフィットが高いと判断したりするなど、全体的に過程や行為、自分自身の葛藤や迷いより結果を重視する回答になっている点が興味深いです。

文・オトナライフ/提供元・オトナライフ

【関連記事】

・ドコモの「ahamo」がユーザー総取り! プラン乗り換え意向調査で見えた驚愕の真実

・【Amazon】注文した商品が届かないときの対処法を解説!

・COSTCO(コストコ)の会員はどれが一番お得? 種類によっては損する可能性も

・コンビニで自動車税のキャッシュレス払い(クレカ・QRコード決済)はどの方法が一番お得?

・PayPay(ペイペイ)に微妙に余っている残高を使い切るにはどうすればいいの!?