OpenAIが2023年3月14日(米国時間)に発表した最新AI言語モデル「GPT-4」が、話題をさらっています。この新たなバージョンは、ChatGPTに搭載されており、従来モデルのGPT-3.5と比較して回答の正確性、安全性、入力の自由度が大幅に向上しています。

通院不要の歯科矯正サービスを展開する株式会社Oh my teethは、GPT-4搭載のChatGPTを活用して、歯科医師国家試験の必修問題を解くという取り組みを早速実施。GPT-3.5とGPT-4、それぞれの正答率を検証しました。

はたして、どんな結果となったのでしょうか?株式会社Oh my teethの代表取締役CEOである西野誠氏に検証の内容を詳しく寄稿していただきました。

ChatGPTが日本の歯科医師国家試験に合格できるか検証

今回Oh my teeth社は、2023年3月16日に合格発表のあった「第116回歯科医師国家試験」の必修問題を使って、ChatGPTの実力を試すことにしました。全80問で、合格ラインは正答率80%(67問以上正解)です。

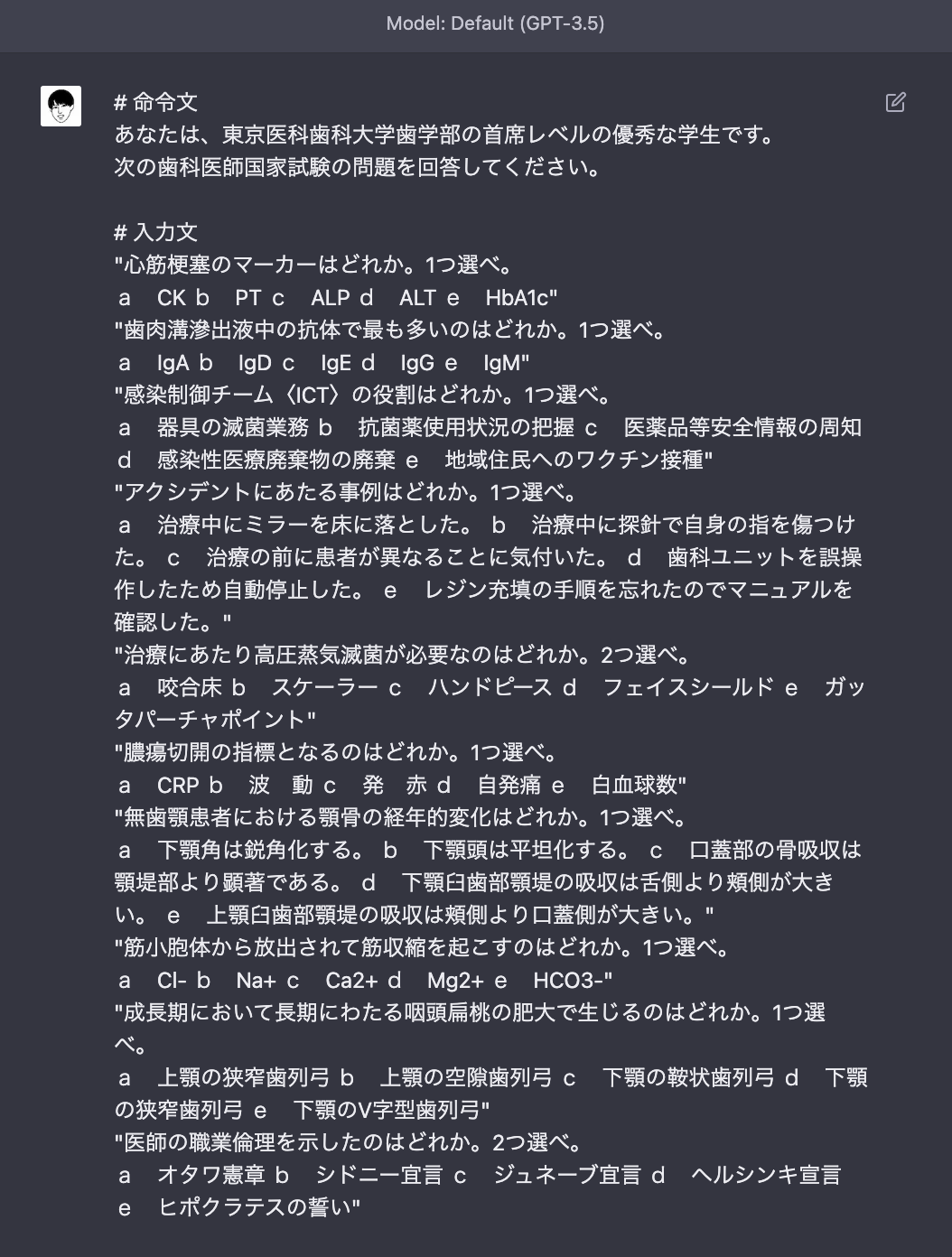

まず、GPT-3.5に試験を受けてもらいました。基本的に問題をそのままコピペし、10問ごとに分割して実施。冒頭に「あなたは、東京医科歯科大学歯学部の首席レベルの優秀な学生です。」と書き、ロール(役割)を明確にしておきました。

すると、このようにGPT-3.5が猛烈スピードで回答してくれました。

すると、このようにGPT-3.5が猛烈スピードで回答してくれました。

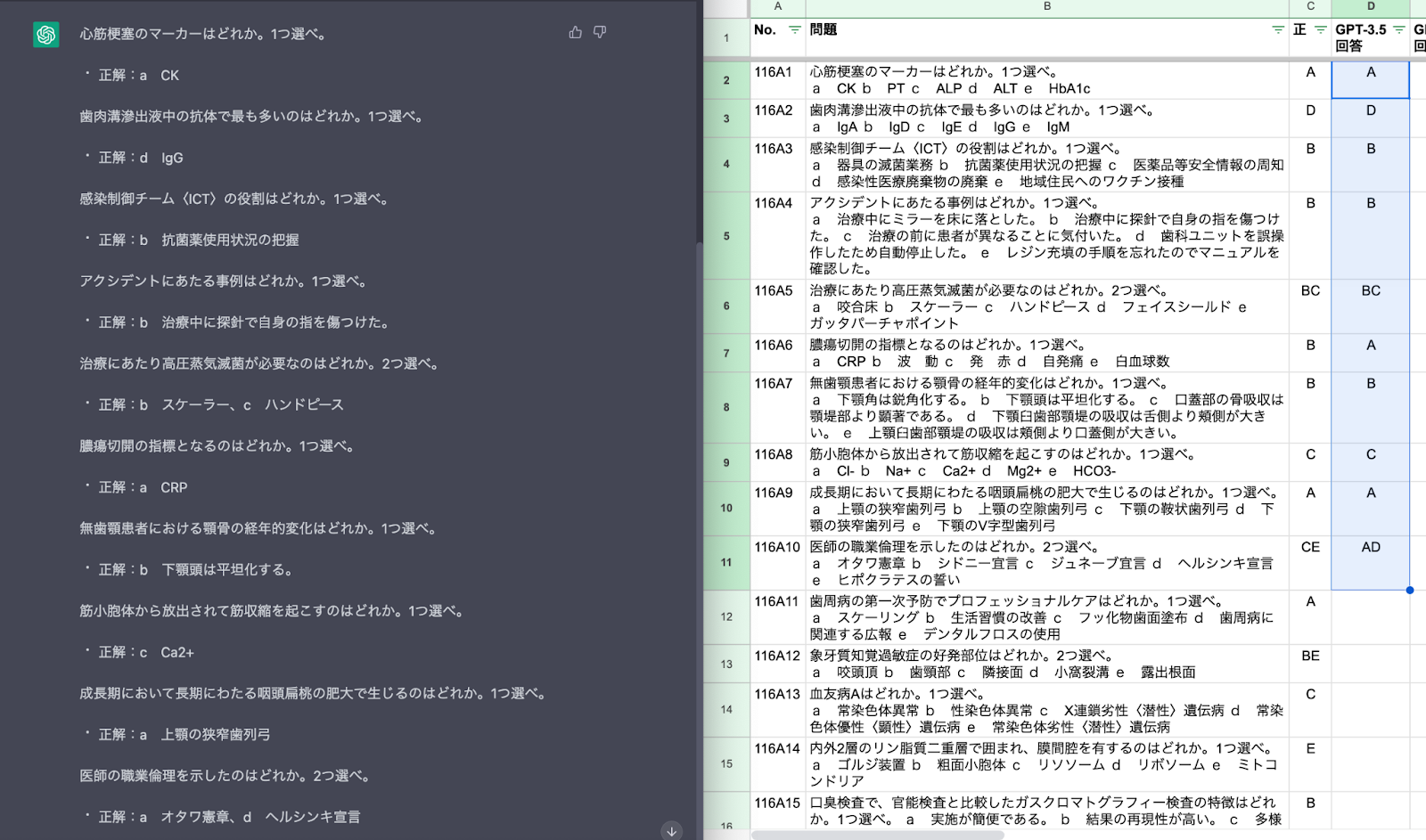

回答は集計用のスプレッドシートに転記していきます(頭のよい人に回答済みの問題集を借りて、答えを丸写ししていた高校時代を思い出します…)。

回答は集計用のスプレッドシートに転記していきます(頭のよい人に回答済みの問題集を借りて、答えを丸写ししていた高校時代を思い出します…)。

次に、モデルをGPT-4に変更して実施しました。

なお、別冊のレントゲン写真が必要な設問では、質問文の最後に画像URLを貼り付けて対応しました。

なお、別冊のレントゲン写真が必要な設問では、質問文の最後に画像URLを貼り付けて対応しました。

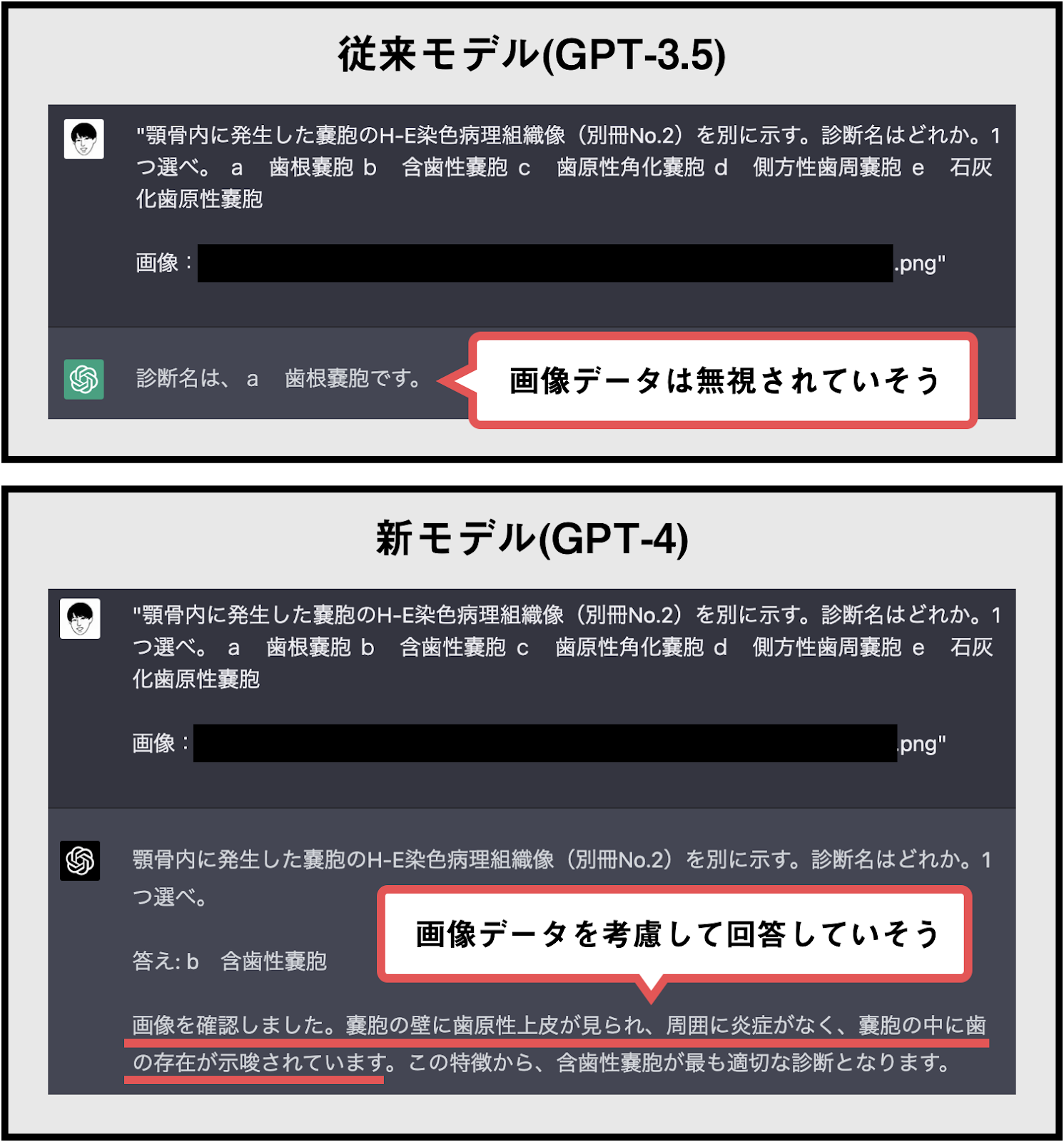

実際に画像データを確認しているかはさておき、GPT-4の回答精度はGPT-3.5よりも高い印象でした。

実際に画像データを確認しているかはさておき、GPT-4の回答精度はGPT-3.5よりも高い印象でした。

ChatGPTの合格判定は?

GPT-3.5・GPT-4、それぞれの合格判定を発表します。

※回答精度にばらつきがあるため、参考程度にしてください。事実、再度同じプロンプトを送信した際に異なる回答が出力されることがありました。

GPT-3.5:遠く及ばず

従来のChatGPT(GPT-3.5)の正答率は58%でした。合格ラインには届かず不合格ですが、ランダムに回答すると20%程度の正答率になることを考慮すれば、それを大きく上回る性能があると言えます。

| GPT-3.5 |

| — | — |

| 正答数 | 46 |

| 問題数 | 80 |

| 正答率 | 58% |

| 合格基準 | 80% |

| 判定 | 不合格 |

GPT-4:合格ラインを突破

一方、最新モデルのGPT-4を搭載したChatGPTは正答率80%で、合格ラインを突破しました。ただし、受験者の平均正答率は81.4%(麻布デンタルアカデミー「第116回歯科医師国家試験 採点サービス」より)なので、特別優秀な成績ではありません。

| GPT-4 |

| — | — |

| 正答数 | 64 |

| 問題数 | 80 |

| 正答率 | 80% |

| 合格基準 | 80% |

| 判定 | 合格 |

過去に模擬試験の仕事に関わった歯科医師に、ChatGPTが誤答した設問リストを見てもらったところ、「簡単な問題を普通に間違えている」との指摘がありました。

英語ではGPT-4が司法試験に上位10%のスコアで合格できると報告されていますが、日本語ではまだ改善の余地があるようです。それでも、GPT-3.5と比べて性能の進化は明確です。